Le MLOps (Machine Learning Operations) désigne l’ensemble des pratiques qui permettent d’industrialiser le cycle de vie d’un modèle de Machine Learning : de l’idée initiale jusqu’à son déploiement et sa surveillance continue.

Inspiré du mouvement DevOps, le MLOps ajoute une contrainte majeure : en plus du code, il faut gérer les données, les modèles et leur évolution dans le temps.

📘 Définition simple : Le MLOps, c’est l’art de transformer un modèle entraîné dans un notebook en un service fiable, surveillé, traçable et améliorable sans bricolage manuel.

L’avenir du MLOps sera façonné par la montée en taille des modèles, l’automatisation profonde des workflows et la nécessité d’une gouvernance fine (audit, éthique, conformité). Les profils capables de faire le lien entre technique, produit et métier seront centraux dans les stratégies IA.

À qui s’adresse ce guide ?

Section intitulée « À qui s’adresse ce guide ? »Ce contenu est conçu pour :

- Des développeurs ou administrateurs système qui veulent comprendre comment “mettre en production” un modèle ML

- Des ingénieurs DevOps / plateforme qui découvrent les spécificités des modèles de données

- Des data scientists souhaitant structurer leurs expérimentations au-delà des notebooks

- Des chefs de projet ou responsables produit cherchant un cadre méthodologique

🎯 Objectif pédagogique : donner une vision claire, progressive et actionnable du MLOps, sans noyer le lecteur dans le jargon.

Qu’est‑ce que le MLOps ?

Section intitulée « Qu’est‑ce que le MLOps ? »Le MLOps est la contraction de Machine Learning et Operations. Il désigne un ensemble de pratiques, outils et processus visant à automatiser et fiabiliser l’ensemble du cycle de vie des modèles de machine learning, du développement à la mise en production, jusqu’à leur maintenance continue.

Pour ceux qui ne connaissent pas le ML, voici une introduction au Machine Learning. Si vous débutez en programmation, consultez d’abord notre guide Python et découvrez Jupyter Notebook pour l’expérimentation interactive.

Objectif principal

Section intitulée « Objectif principal »L’objectif du MLOps est clair : permettre aux équipes data science, DevOps et produit de collaborer efficacement pour livrer des modèles ML robustes, traçables et maintenables dans le temps, tout en répondant aux exigences de l’entreprise (qualité, sécurité, scalabilité).

Différences entre MLOps et DevOps

Section intitulée « Différences entre MLOps et DevOps »Bien que le MLOps s’inspire directement du DevOps, plusieurs différences fondamentales apparaissent :

| Aspect | DevOps | MLOps |

|---|---|---|

| Artefacts à déployer | Code source | Code + données + modèles |

| Tests | Tests unitaires, intégration | Tests + validation statistique du modèle |

| Déploiement | CI/CD | CI/CD + surveillance des performances |

| Monitoring | Logs, erreurs, uptime | Drift de données, précision, biais |

| Reproductibilité | Builds identiques | Reproduire expériences avec versions datasets |

Le code ne suffit plus : il faut versionner, monitorer et maintenir les données, les features, et les modèles.

📌 À retenir : en MLOps, un “artefact” = code + données + configuration + poids du modèle. Sans traçabilité complète, impossible d’expliquer un résultat ou de corriger un incident.

Pourquoi adopter le MLOps ?

Section intitulée « Pourquoi adopter le MLOps ? »Voici quelques bénéfices concrets de l’adoption du MLOps :

- Automatisation des déploiements des modèles, réduisant les délais entre la recherche et la production.

- Reproductibilité des expériences grâce au versioning des datasets et des hyperparamètres.

- Surveillance en temps réel des performances des modèles et détection des dérives.

- Collaboration renforcée entre équipes data, ops et produit.

- Réduction du risque de modèle obsolète, non documenté ou non traçable.

Selon Gartner, plus de 50 % des modèles ML développés ne sont jamais déployés en production sans un cadre MLOps structuré.

Niveaux de maturité MLOps

Section intitulée « Niveaux de maturité MLOps »Le MLOps peut être vu comme un chemin de progression. Voici trois niveaux communément admis :

-

Niveau 0 : manuel Les notebooks sont exécutés localement, les modèles déployés manuellement, sans versioning ni tests.

-

Niveau 1 : automatisé partiellement Les pipelines d’entraînement sont codifiés, les modèles sont stockés, et les déploiements semi-automatisés.

-

Niveau 2 : automatisé & intégré Intégration continue (CI) + déploiement continu (CD) + surveillance en production avec déclenchement d’alertes ou de réentraînement.

Pour un cadre plus avancé, voir le Unified MLOps Lifecycle Model dans cette étude académique.

Le MLOps devient un pilier stratégique pour les entreprises souhaitant exploiter durablement l’intelligence artificielle.

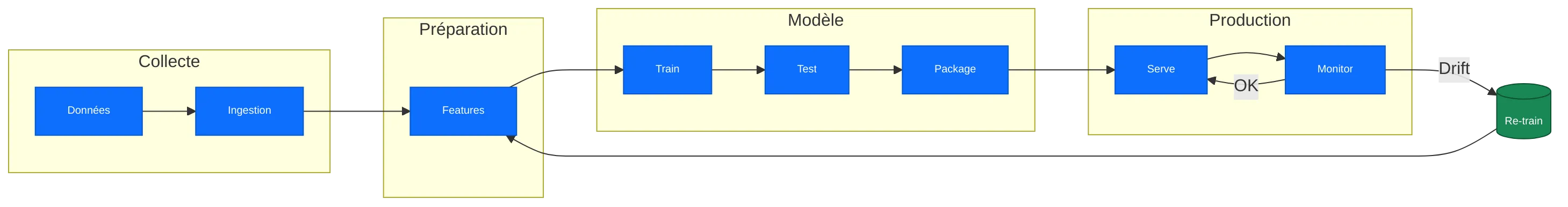

Cycle de vie d’un pipeline MLOps

Section intitulée « Cycle de vie d’un pipeline MLOps »Le pipeline MLOps est un enchaînement d’étapes automatisées permettant de transformer des données brutes en modèles déployés, surveillés et maintenus en production. Chaque étape a ses outils, ses contrôles et ses défis.

Collecte et ingestion des données

Section intitulée « Collecte et ingestion des données »Tout commence par la collecte : données structurées, non structurées, logs, APIs, capteurs, etc. Ces données doivent être ingérées dans un système centralisé :

- Utilisation d’outils comme Airbyte, Apache NiFi, ou Kafka.

- Contrôles qualité automatisés : valeurs manquantes, doublons, formats incohérents.

- Versioning des jeux de données avec DVC ou LakeFS pour la traçabilité.

Nettoyage et Feature Engineering

Section intitulée « Nettoyage et Feature Engineering »Les données sont ensuite prétraitées : normalisation, encodage, enrichissement, détection d’anomalies. Cette étape est critique pour la qualité du modèle.

- Pipelines réutilisables avec scikit-learn, Spark, Featuretools en Python.

- Validation automatisée avec Great Expectations.

Astuce : factorisez les transformations dans un pipeline unique utilisable à l’entraînement et en production.

Entraînement et évaluation du modèle

Section intitulée « Entraînement et évaluation du modèle »C’est le cœur du processus. L’entraînement s’effectue souvent sur des clusters GPU/TPU ou dans des notebooks orchestrés.

- Suivi des expériences avec MLflow, Weights & Biases ou Comet.

- Tests croisés, scoring, sélection des meilleurs modèles.

- Automatisation via training pipeline (ex. : Kubeflow, ZenML).

📘 Terme clé – « Feature » : une feature est une information (colonne, signal, mesure) fournie en entrée du modèle pour l’aider à prédire la variable cible.

Packaging et déploiement du modèle

Section intitulée « Packaging et déploiement du modèle »Une fois entraîné, le modèle doit être exporté, packagé (souvent dans un conteneur) puis déployé dans un environnement cible (API REST, batch, edge…).

- Formats standards : ONNX, Joblib, Pickle, TorchScript (JSON compatible).

- Déploiement avec Seldon, BentoML, TorchServe ou FastAPI.

- CI/CD avec GitHub Actions, ArgoCD, Jenkins.

📘 CI/CD : Continuous Integration / Continuous Delivery. Chaque changement est testé automatiquement, puis peut être déployé rapidement et de manière fiable.

Monitoring et gestion du drift

Section intitulée « Monitoring et gestion du drift »Le modèle déployé doit être surveillé en continu : latence, précision, consommation de ressources, dérive des données.

- Outils : Evidently AI, Prometheus + Grafana, Fiddler.

- Détection automatique de dérive (data drift, concept drift).

- Mécanismes d’alerte et déclenchement d’un nouveau pipeline de réentraînement.

📌 À retenir : le drift se produit quand les données ou leur relation au phénomène étudié changent. Un modèle peut rester “techniquement en ligne” mais devenir silencieusement moins pertinent.

Réentraînement et boucle de rétroaction

Section intitulée « Réentraînement et boucle de rétroaction »Les données évoluent : pour rester pertinent, le modèle doit être réentraîné régulièrement.

- Fréquence : horaire, quotidienne, hebdomadaire, selon le cas d’usage.

- Possibilité d’apprentissage continu ou incrémental.

- Archivage et traçabilité via un registre de modèles (model registry).

Chaque étape du pipeline doit être modulaire, versionnée et automatisée pour assurer scalabilité et fiabilité. Dans le prochain chapitre, nous verrons les bonnes pratiques à appliquer pour construire un pipeline MLOps maintenable et robuste.

💡 Bon réflexe : documenter le “pourquoi” d’un réentraînement (drift détecté, changement réglementaire, nouveau segment utilisateur) dans le registre de modèles.

Bonnes pratiques clés

Section intitulée « Bonnes pratiques clés »Construire un pipeline MLOps performant ne se résume pas à empiler des outils. Il s’agit d’appliquer des bonnes pratiques pour garantir la qualité, la sécurité et la maintenabilité du système de bout en bout. Voici les fondations essentielles.

Versioning des données, modèles et expériences

Section intitulée « Versioning des données, modèles et expériences »Le versioning est au cœur du MLOps. Il permet de reproduire une expérience passée, de comparer des modèles et de tracer l’origine de chaque décision.

- Utilisez DVC, LakeFS ou Pachyderm pour versionner les jeux de données.

- Employez un registry de modèles (MLflow, SageMaker Model Registry) pour stocker et versionner les modèles entraînés.

- Enregistrez chaque exécution avec les hyperparamètres, métriques et artefacts.

Infrastructure as Code (IaC) et reproductibilité

Section intitulée « Infrastructure as Code (IaC) et reproductibilité »L’IaC permet de décrire toute votre infrastructure dans du code, versionné avec Git. Cela facilite la reproductibilité et réduit les erreurs humaines.

- Déployez vos environnements avec Terraform, Pulumi ou Ansible.

- Décrivez vos workflows avec Argo Workflows, Kubeflow Pipelines, ou Flyte.

- Automatisez la création des environnements de test, staging et production.

Tests pour modèles ML

Section intitulée « Tests pour modèles ML »Tester un modèle, ce n’est pas seulement vérifier qu’il tourne. Il faut valider son comportement, sa stabilité et son impact métier.

- Tests unitaires : vérifient que chaque composant (feature engineering, pipeline, métrique) fonctionne correctement.

- Tests de performance : compare les résultats sur différents jeux de données.

- Tests de robustesse : ajout de bruit, gestion des valeurs aberrantes.

- Tests d’intégration : vérifier le bon fonctionnement de bout en bout.

📘 Inference : phase où le modèle reçoit de nouvelles données et produit une prédiction (ex: probabilité de churn). Optimiser l’inférence = réduire latence et coût.

Automatisation avec CI/CD

Section intitulée « Automatisation avec CI/CD »L’automatisation est essentielle pour passer à l’échelle. Le CI/CD pour le ML (aussi appelé CI/CD/CT – continuous training) réduit les délais de livraison et augmente la fiabilité.

- Déclenchez les pipelines à chaque commit via GitHub Actions, GitLab CI, ou Jenkins.

- Intégrez des étapes de tests, entraînement, validation, packaging et déploiement.

- Déployez en staging, validez, puis promouvez vers la production automatiquement ou manuellement.

📌 À retenir : le “CT” (Continuous Training) étend la CI/CD classique en ajoutant la capacité à réentraîner automatiquement selon des règles (drift, volume de nouvelles données, date planifiée).

Gestion des erreurs et sécurité

Section intitulée « Gestion des erreurs et sécurité »Le pipeline ML ne doit pas s’arrêter au moindre souci. Il faut prévoir des mécanismes de tolérance aux pannes et des alertes.

- Implémentez des retries sur les étapes critiques.

- Utilisez des outils comme Sentry, Datadog, ou Prometheus pour la supervision.

- Sécurisez les données sensibles avec des politiques d’accès, chiffrement, et un stockage isolé.

🔒 Sécurité MLOps : pensez “chaîne d’approvisionnement ML” (supply chain). Un artefact modèle doit être signé, vérifiable et isolé comme n’importe quelle binaire critique.

En appliquant ces bonnes pratiques, vous passez d’un pipeline artisanal à une plateforme fiable et évolutive. Dans le chapitre suivant, nous verrons quels sont les outils clés du MLOps, leur rôle et comment les combiner efficacement.

Outils & plateformes MLOps

Section intitulée « Outils & plateformes MLOps »Le paysage des outils MLOps est vaste et en constante évolution. Chaque outil remplit un rôle spécifique dans le cycle de vie du modèle : ingestion, entraînement, orchestration, déploiement, supervision, etc. L’objectif est de construire une chaîne outillée cohérente, adaptée à vos besoins et à votre niveau de maturité.

Outils open source populaires

Section intitulée « Outils open source populaires »Voici une sélection d’outils MLOps classés par catégorie d’usage :

- Orchestration et pipelines :

- Kubeflow Pipelines : orchestration de workflows sur Kubernetes.

- ZenML : framework modulaire pour automatiser les pipelines ML.

- Flyte : plateforme orientée production pour des workflows robustes.

- Dagster / Prefect : orchestration orientée données.

- Suivi des expérimentations :

- MLflow : suivi des runs, modèles, métriques et artefacts.

- Weights & Biases : tracking avancé avec visualisation et collaboration.

- Comet.ml : suivi des expériences, gestion d’équipe, reproductibilité.

- Packaging et déploiement :

- BentoML : création d’APIs REST pour vos modèles ML.

- Seldon Core : déploiement scalable sur Kubernetes.

- TorchServe / TF Serving : serving dédié pour PyTorch / TensorFlow.

- Monitoring et gestion du drift :

- Evidently AI : analyse de dérive, qualité des données, détection automatique.

- WhyLabs : monitoring en production, alertes sur les performances.

- Arize AI : suivi du drift, des biais et de l’impact métier en temps réel.

- Versioning et traçabilité :

- DVC : versioning de données et de modèles.

- LakeFS : système de versioning Git-like pour les data lakes.

- Pachyderm : pipeline reproductible et versionné.

💡 Choix outil : commencez simple (MLflow + DVC) avant d’adopter des plateformes plus complexes pour éviter la dette opérationnelle prématurée.

Comparatif rapide des usages

Section intitulée « Comparatif rapide des usages »| Besoin | Outils recommandés |

|---|---|

| Orchestration de workflows | Kubeflow, Flyte, ZenML, Dagster |

| Tracking des expériences | MLflow, W&B, Comet.ml |

| Déploiement de modèles | Seldon, BentoML, FastAPI |

| Monitoring et drift | Evidently, Arize AI, WhyLabs |

| Versioning données/modèles | DVC, LakeFS, Pachyderm |

👉 Une architecture typique combine plusieurs de ces outils avec des services cloud (AWS, Azure, GCP, OUTSCALE).

Intégration avec le cloud et conteneurs

Section intitulée « Intégration avec le cloud et conteneurs »La majorité des outils MLOps sont conçus pour fonctionner dans des environnements cloud-native et conteneurisés :

- Déploiement sur Kubernetes avec Helm ou Kustomize.

- Intégration avec CI/CD cloud (GitHub Actions, GitLab CI, Azure DevOps, … CodePipeline).

- Stockage cloud pour les artefacts : S3, GCS, Blob Storage.

Exemple : un modèle est entraîné avec MLflow, packagé avec BentoML, déployé sur Kubernetes via Seldon, monitoré par Evidently.

Cas pratiques d’architecture MLOps

Section intitulée « Cas pratiques d’architecture MLOps »Voici un exemple de chaîne MLOps modulaire :

- Collecte & ingestion : Airbyte → S3

- Pipeline d’entraînement : ZenML + MLflow

- Packaging & déploiement : BentoML → Seldon

- Surveillance : Evidently AI + Prometheus

- Réentraînement automatique : déclenché via Flyte / Argo Workflows

Cette architecture peut évoluer avec le temps selon les besoins : scalabilité, sécurité, automatisation avancée, intégration LLMOps…

Défis & obstacles à l’adoption

Section intitulée « Défis & obstacles à l’adoption »Mettre en place un pipeline MLOps complet est loin d’être un simple exercice technique. Les organisations rencontrent souvent des obstacles structurels, humains et technologiques. Voici les principaux freins identifiés et des pistes concrètes pour les dépasser.

Freins organisationnels et culturels

Section intitulée « Freins organisationnels et culturels »L’un des défis majeurs est l’alignement entre les équipes :

- Les data scientists se concentrent sur la modélisation.

- Les ingénieurs pensent en termes de déploiement, scalabilité et sécurité.

- Le manque de communication entre ces profils ralentit la mise en production.

Solutions :

- Mettre en place des équipes hybrides ou des “ML Engineers” en interface.

- Promouvoir une culture de la collaboration interdisciplinaire.

- Utiliser des outils partagés et un vocabulaire commun.

Manque de compétences en MLOps

Section intitulée « Manque de compétences en MLOps »Le MLOps est encore un domaine jeune, avec peu de profils réellement expérimentés.

- Les ingénieurs ont rarement une maîtrise complète de l’apprentissage machine.

- Les data scientists sont rarement formés à l’automatisation, la CI/CD, ou Kubernetes.

Solutions :

- Proposer des formations internes ciblées (DevOps → ML ; Data → Infra).

- Faire appel à des mentors ou consultants externes pour démarrer.

- S’appuyer sur des outils low-code / no-code pour certaines briques.

Gouvernance, sécurité et conformité

Section intitulée « Gouvernance, sécurité et conformité »Les projets ML touchent souvent à des données sensibles ou régulées (RGPD, HIPAA, etc.).

- Difficulté à auditer les modèles : d’où viennent les données ? quelles transformations ?

- Risque juridique en cas de biais algorithmique non détecté.

- Problèmes d’accès aux environnements de prod par les équipes data.

Solutions :

- Imposer le versioning complet des datasets et modèles.

- Mettre en place des processus de validation éthique des modèles.

- Cloisonner les accès avec des droits finement définis (IAM, RBAC).

Dette technique et complexité du pipeline

Section intitulée « Dette technique et complexité du pipeline »Les pipelines ML deviennent vite fragiles et opaques si mal construits :

- Scripts éparpillés, sans orchestration.

- Code non testé, non versionné.

- Multiplication des outils sans standardisation.

Solutions :

- Structurer le projet dès le départ avec un pipeline modulaire.

- Centraliser les logs, métriques et artefacts.

- Standardiser les composants : noms de datasets, types de modèles, formats.

Études et retours d’expérience

Section intitulée « Études et retours d’expérience »Selon une étude publiée dans Journal of Systems and Software (lien), les principaux obstacles à l’adoption du MLOps sont :

- 69 % : manque de compétences internes

- 58 % : intégration difficile aux systèmes existants

- 45 % : manque de vision produit sur les modèles ML

- 41 % : dérive des performances non détectée à temps

Adopter le MLOps ne se résume donc pas à installer des outils : c’est un changement de culture, de méthode, et de gouvernance.

Surveillance, maintenance et drift

Section intitulée « Surveillance, maintenance et drift »Une fois un modèle déployé, le travail ne fait que commencer. Il doit être surveillé, maintenu et mis à jour régulièrement pour rester pertinent. Ignorer cette étape conduit à une dérive des performances et à des décisions erronées. C’est ici que les pratiques de monitoring et de gestion du drift prennent tout leur sens.

En résumé : déployer n’est pas la fin — c’est le début de la phase d’apprentissage en conditions réelles.

📘 Drift (dérive) : situation où les données actuelles ne ressemblent plus assez aux données d’entraînement initiales ou où la relation phénomène ↔ données a changé. Résultat : baisse progressive de la qualité.

Types de dérive à surveiller

Section intitulée « Types de dérive à surveiller »Il existe principalement deux formes de drift qui peuvent impacter la qualité des prédictions :

- Data Drift : changement dans la distribution des données d’entrée (features). Exemple : nouvelle saison, évolution du comportement utilisateur.

- Concept Drift : changement dans la relation entre les features et la variable cible. Exemple : la définition de la fraude évolue dans le temps.

Autres phénomènes à prendre en compte :

- Model Drift : perte de précision du modèle avec le temps.

- Target Drift : changement dans la distribution des labels (souvent indirect).

Indicateurs à surveiller

Section intitulée « Indicateurs à surveiller »Un bon système de monitoring MLOps doit suivre plusieurs indicateurs clés :

- Taux de prédiction erronée (si les labels sont disponibles)

- Distribution des features en entrée

- Scores statistiques de drift (KL divergence, PSI)

- Temps de réponse et disponibilité du modèle

- Taux d’utilisation de chaque classe prédite (déséquilibre, biais)

Exemple avec Evidently :

from evidently.report import Reportfrom evidently.metric_preset import DataDriftPreset

report = Report(metrics=[DataDriftPreset()])report.run(reference_data=dataset_train, current_data=dataset_prod)report.save_html("drift_report.html")Outils de surveillance

Section intitulée « Outils de surveillance »Voici quelques outils open source ou SaaS dédiés à la surveillance des modèles :

- Evidently AI : analyse du drift, qualité des données, rapport HTML interactif.

- Fiddler AI : monitoring, auditabilité, détection des biais.

- WhyLabs : intégration facile, visualisation, alertes personnalisées.

- Prometheus + Grafana : monitoring technique (latence, uptime).

- Arize AI : suivi détaillé des performances modèles et dérives en temps réel.

Stratégies de réentraînement

Section intitulée « Stratégies de réentraînement »Quand un drift est détecté, plusieurs actions sont possibles :

- Réentraînement programmé : relancer un pipeline complet à intervalle fixe (hebdo, mensuel).

- Réentraînement déclenché par événement : déclenché automatiquement en cas de dégradation.

- Apprentissage incrémental : mise à jour continue du modèle (sous conditions).

- Rollback : retour à une version précédente plus stable.

📌 À retenir : réentraîner trop souvent gaspille des ressources ; pas assez souvent dégrade la valeur métier. Mesurez et définissez des seuils explicites.

Approche avancée : réutilisation de modèles

Section intitulée « Approche avancée : réutilisation de modèles »Selon SimReuse, une approche consiste à réutiliser un ancien modèle si la distribution des données n’a pas changé de manière significative. Cela réduit le coût de maintenance.

Un modèle plus ancien, mais mieux adapté à la distribution actuelle, peut surperformer un modèle fraîchement réentraîné.

La mise en place d’un système de surveillance intelligent est une des étapes les plus critiques du MLOps moderne. Dans le prochain chapitre, nous verrons comment ces pratiques se traduisent dans des cas d’usage réels, avec des retours d’expérience concrets.

L’avenir du MLOps

Section intitulée « L’avenir du MLOps »Les principales tendances qui se dessinent : intégration plus poussée avec le cloud natif (Kubernetes, serverless), gouvernance avancée des modèles (ML audit, explainability, cartes de performance), rôle stratégique accru du MLOps Engineer dans l’organisation, automatisation avancée du réentraînement via modèles auto‑adaptatifs, et standardisation des outils avec l’émergence de stacks complètes (Tecton, Vertex AI, Azure ML…).

Selon neptune.ai, la tendance est à l’unification des plateformes MLOps et à l’intégration verticale (feature store + training + monitoring + serving).

L’avenir du MLOps sera façonné par l’échelle croissante des modèles, l’automatisation des workflows, et la nécessité d’une gouvernance fine. Les ingénieurs qui sauront maîtriser ces outils et faire le lien entre technique, produit et métier seront au cœur des stratégies IA de demain.